Liunx安装elasticsearch7.6、ik分词器及kibana可视化工具

”Elasticsearch7.6 ik分词器 中文分词器“ 的搜索结果

一、什么是IK分词器? 分词:即把一段中文或英文划分成一个个的关键字,我们在搜索时会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作。默认的中文分词是将每个字看成一个词...

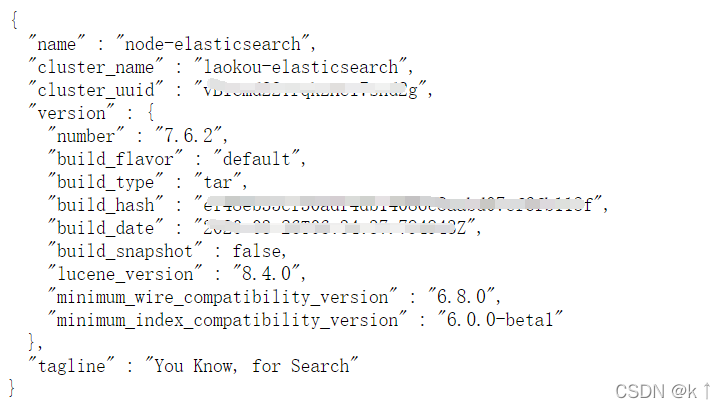

用于elasticsearch7.6.2配套的中文分词器,欢迎大家使用 下面是它的描述,用于elasticsearch7.6.2配套的中文分词器,

下载ik分词器,注意要和自己的ElasticSearch版本号一模一样才行,如果不一样可能会有冲突,比如说你ElasticSearch用的是7.6.1版本,那么ik分词器也要是7.6.1,不然就可能启动不成功. 如果你是集群环境,那么就将ik分词器...

公司es集群现以三个角色部署分别为 Gateway、Master、Data 简单的理解可以理解为在每台机器上部署了三个es,以端口和配置文件来区分这三个es不同的...启动用户:elasticsearch su elasticsearch路径:/opt 三个es进程。

2020年4月最新ES压缩包: 包含: elasticsearch-7.6.2-linux-x86_64.tar elasticsearch-analysis-ik-7.6.2 kibana-7.6.2-linux-x86_64.tar 链接:https://pan.baidu.com/s/1c4dnND9KLA2thrI7l47-_Q

官网最新版Elasticsearch 7.6 logstash ik中文分词器下载

分词:把一段中文或者别的划分成一个一个的关键字,我们在搜索的时候会把自己的信息...“爱”,“魏”,“一”,“鹤”,这显然是不符合要求的,索引我们需要安装中文分词器IK来解决这个问题如果要使用中文,建议使用ik分词器。

windows上ES安装ik分词器

关于es7.6同义词的内容真的好难找…………现在简单记录一下实现过程1、安装同义词插件插件下载传送,其他的同义词插件未测试2、插件使用mvn打包(最新版master没有打包), 使用maven编译插件打包提示需要修改elastic...

安装IK分词器 3.1.在线安装ik插件(较慢) 3.2.离线安装ik插件(推荐) 1)查看数据卷目录 2)解压缩分词器安装包 3)上传到es容器的插件数据卷中 4)重启容器 5)测试: 3.3 扩展词词典 ☀️4.部署es集群

目录es相关概念ik分词器ik分词器的测试ik分词器增加自己的词 es相关概念 elasticsearch(集群)中可以包含多个索引(数据库),每个索引中可以包含多个类型(表),每个类型下又包 含多 个文档(行),每个文档中又包含多个...

安装包提取码:k473使用教程。

vi elasticsearch.yml 编辑elasticsearch.yml 文件。cd /usr/share/elasticsearch/config/ cd到config目录。docker exec -it elasticsearch /bin/bash 交互式进入容器。或者使用数据卷直接绑定,动态修改配置文件。...

安装IK分词器

Ik分词器支持默认分词器,可以扩展分词词典,但想扩展一个分词器类型就需要个性IK源码了,扩展后的分词器与原生分词器可混用,也可单独使用。 下面简单介绍下修改过程同大家分享共同学习。 过程: 1、克隆IK源码并...

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.2.0/elasticsearch-analysis-ik-6.2.0.zip 3、查看安装目录 ll plugins/analysis-ik/

因为Elasticsearch中默认的标准分词器分词器对中文分词不是很友好,会将中文词语拆分成一个一个中文的汉子。因此引入中文分词器插件 Elasticsearch拼音分词和IK分词的安装及使用 一、Es插件配置及下载 1.IK分词器...

kibana-7.6.2-linux-x86_64.tar.gz elasticsearch-7.6.2-linux-x86_64.tar.gz ...elasticsearch-analysis-ik-7.6.2.zip 链接:https://pan.baidu.com/s/1WXX1t2kzwFRSEzJqx5Of5w 提取码:4lbc 官网是真慢 ...

推荐文章

- 机器学习之超参数优化 - 网格优化方法(随机网格搜索)_网格搜索参数优化-程序员宅基地

- Lumina网络进入SDN市场-程序员宅基地

- python引用传递的区别_php传值引用的区别-程序员宅基地

- 《TCP/IP详解 卷2》 笔记: 简介_tcpip详解卷二有必要看吗-程序员宅基地

- 饺子播放器Jzvd使用过程中遇到的问题汇总-程序员宅基地

- python- flask current_app详解,与 current_app._get_current_object()的区别以及异步发送邮件实例-程序员宅基地

- 堪比ps的mac修图软件 Pixelmator Pro 2.0.6中文版 支持Silicon M1_pixelmator堆栈-程序员宅基地

- 「USACO2015」 最大流 - 树上差分_usaco 差分-程序员宅基地

- Leetcode #315: 计算右侧小于当前元素的个数_找元素右边比他小的数字-程序员宅基地

- HTTP图解读书笔记(第六章 HTTP首部)响应首部字段_web响应的首部内容-程序员宅基地